要说大语言模型,GPT-3绝对算得上重量级的翘楚佼佼者。锋芒一出,无AI出其右。这货不仅大,能力强,而且很迷,由于种种原因,太过扭捏不够开放,机智客觉得GPT这货(其实不仅是3了),可谓创造了一个规模和能力的制高点,又独领神秘风骚。现在人工智能界都不太清楚它内部的秘密,不过时代在发展,技术在进步,更卓越更Open的大语言模型,来挑战GPT-3了。

这个挑战,不仅要在表现能力上不能败北,而且还要比GPT-3更环保更开放。这个更优秀的就是Meta AI复刻GPT-3的大模型OPT-175B。机智客看到相关释义,OPT全称Open Pre-trained Transformer Language Models,即“开放的预训练Transformer语言模型”。没错,复刻你,还要打败你。比你开放比你高效能。

正因为为了更环保更“Open”的大众,所以OPT-175B运行时产生的碳消耗连GPT-3的1/7都不到,而且性能方面,Meta AI针对OPT-175B和GPT-3,用14个NLP任务进行了测试。无论是零样本学习(zero-shot)还是多样本学习(Multi-shot),OPT在这些任务上的平均精度都与GPT-3相差不大。而在在对话任务中,采用无监督学习的方法训练OPT-175B,效果和监督学习训练的几类模型相近。

如果这些你没有直观感受的话,那么回到硬件方面,更直观一点来看下,再看看训练硬件方面,Meta AI用了992块英伟达A100 GPU(80GB)训练OPT,平均每块GPU的计算效率最高能达到147 TFLOP/s。更有甚者,Meta AI甚至还这么表示,最低只需要16块英伟达V100 GPU,就能训练并部署OPT-175B模型。

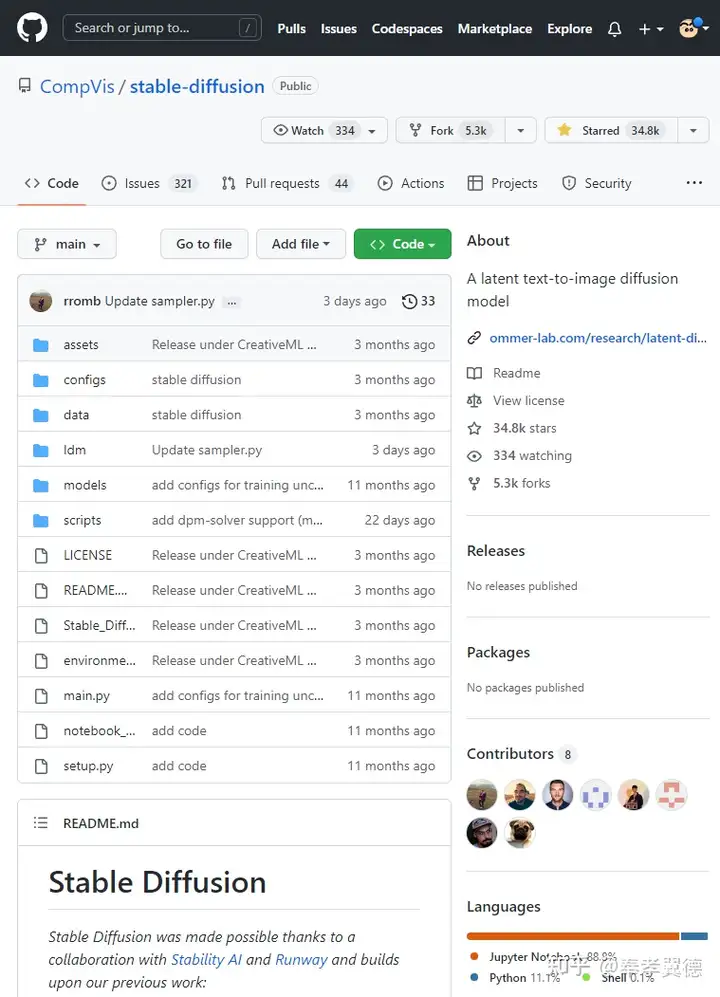

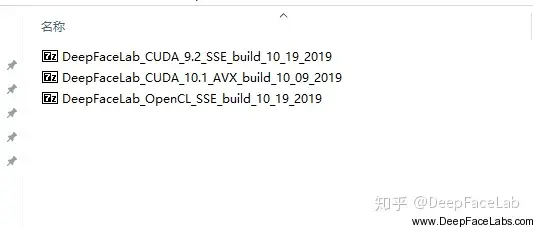

当然如同世界上任何一个发展中的技术一样,这个OPT-175B模型也不是没有问题。比如语言生成上的确会出现一些不可控的违背道德的语言。研究人员就是希望开放出来,有更多人参与进来真正解决这些问题。目前最高30B规模的预训练网络模型已经开放到GitHub,更高的66B还在路上,更最顶级的则需要填表注册申请。

哈,Open AI名不符其实,Open AI不Open,终于有同样优秀的人(大语言模型)Open出来教他做人了,机智客个人想,这样能开放研究的才是真的、促进科技发展的Open AI吧。

暂无评论内容