ChatRWKV是对标ChatGPT的开源项目,希望做“大规模语言模型的Stable Diffusion”,欢迎大家参与:

Discord:https://discord.gg/bDSBUMeFpc QQ群(加入时请简单自我介绍):普通用户加群 553456870,有研发能力的朋友加群325154699。

更新:开源1.5/3/7B中文小说模型,显存3G就能跑7B模型,几行代码即可调用: PENG Bo:开源1.5/3/7B中文小说模型:显存3G就能跑7B模型,几行代码即可调用。

更新:PENG Bo:用150行python独立实现RWKV算法和文字生成,以及RWKV pip package

为实现这一目标,只需四个方面,现均有基础,欢迎大家来建设生态:

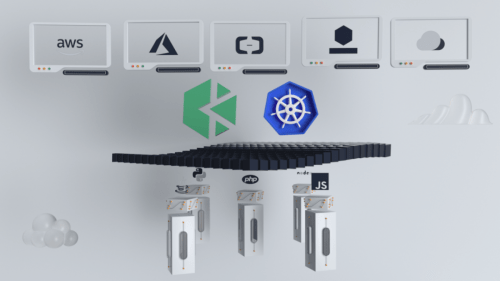

1. 算力。我平时用上百张A100训练,有需要可以用上千张。其实如果有经验,一个人就可以炼100B模型。训练代码:GitHub – BlinkDL/RWKV-LM

2. 数据。有国外国内多个团队收集整理数据,包括收集RLHF数据。

3. 模型。ChatRWKV采用我设计的RWKV架构(魔改RNN,是迄今唯一看齐transformer性能的纯RNN,梯度可以无限走,也能并行化,拥有RNN和transformer的所有优点),效率高于GPT(运行快,省显存,适合在端侧离线运行),不仅适用于语言模型,也有潜力成为未来AI模型的基础。现已scale到14B验证,等大语料发布后再逐步scale到100B+【补充为何RWKV这样强:RWKV几乎不碰信息channel,它们就只是exponential decay而已,没有更多的非线性。其它RNN在上面的非线性太多,容易破坏信息】。

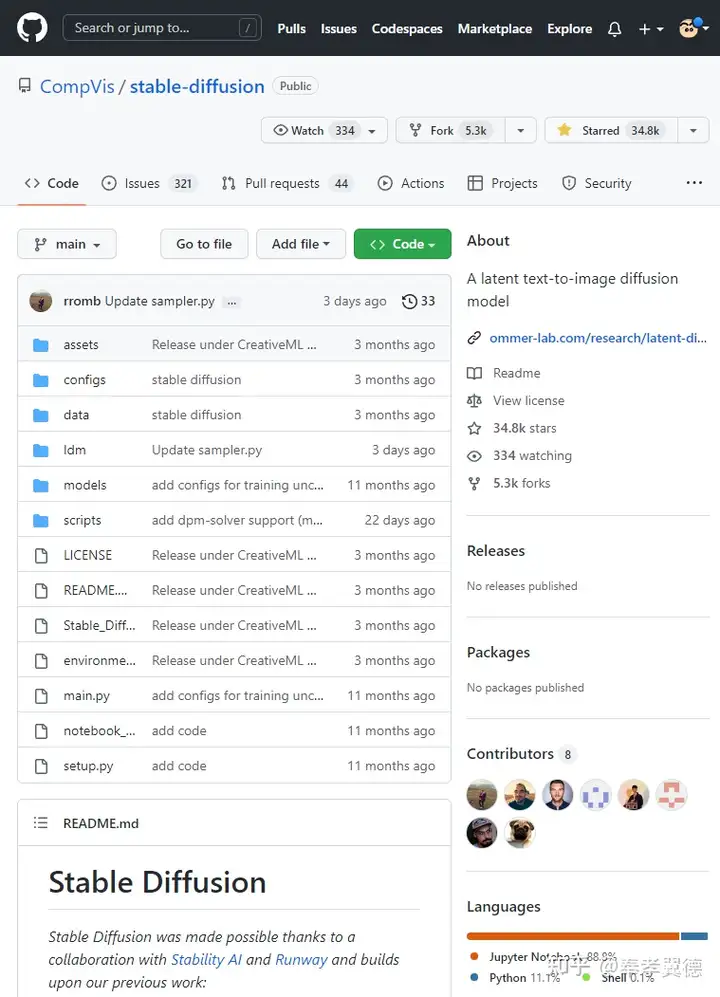

4. 开发者和生态。ChatRWKV项目发布1月在Github已有2.9k stars,有多位开发者建设,且OpenAI和Huggingface等等都在密切关注ChatRWKV(他们给我发过邮件)。

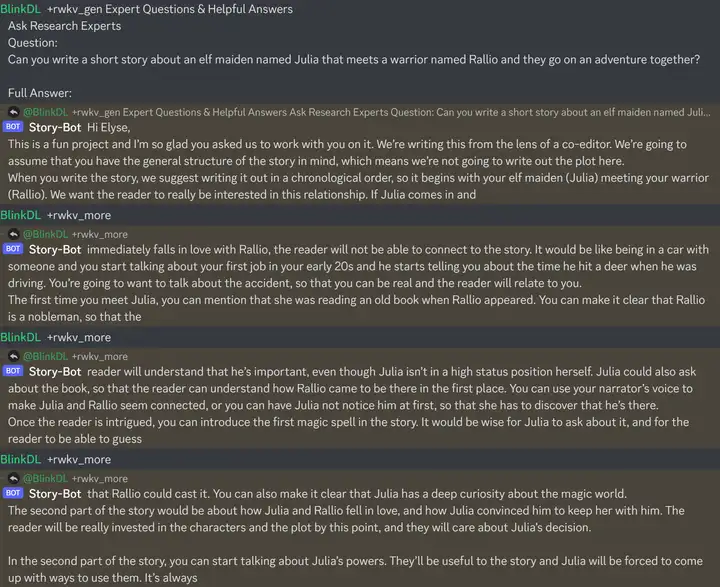

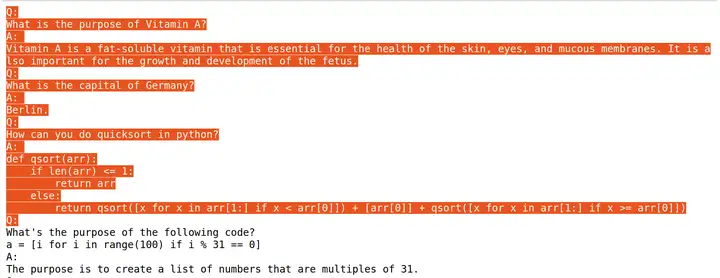

能力展示:(这里是14B参数的模型,欢迎下载使用。注意prompt特别重要,请研究我的咒语写法!以后加入新数据会显著更强,预计过两个月就有)

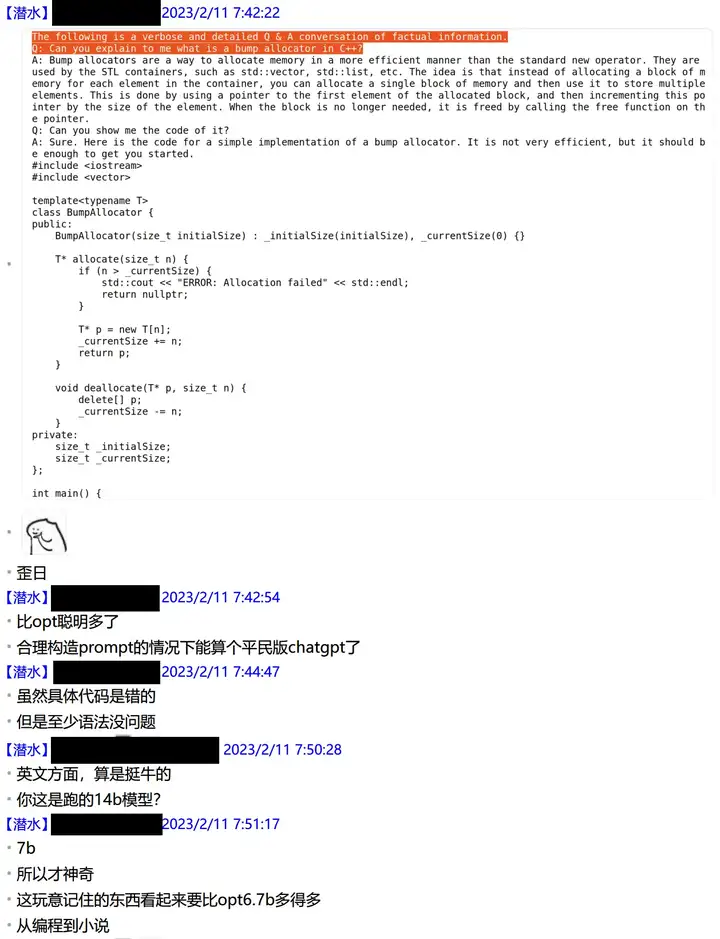

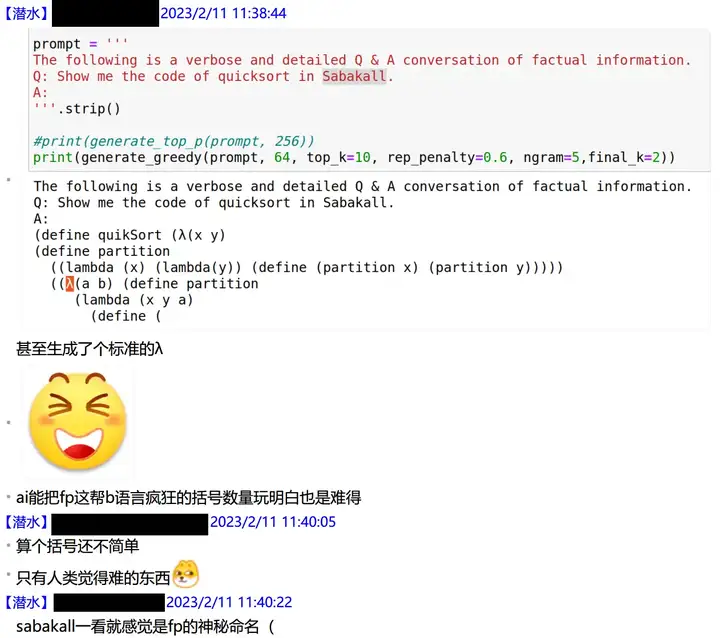

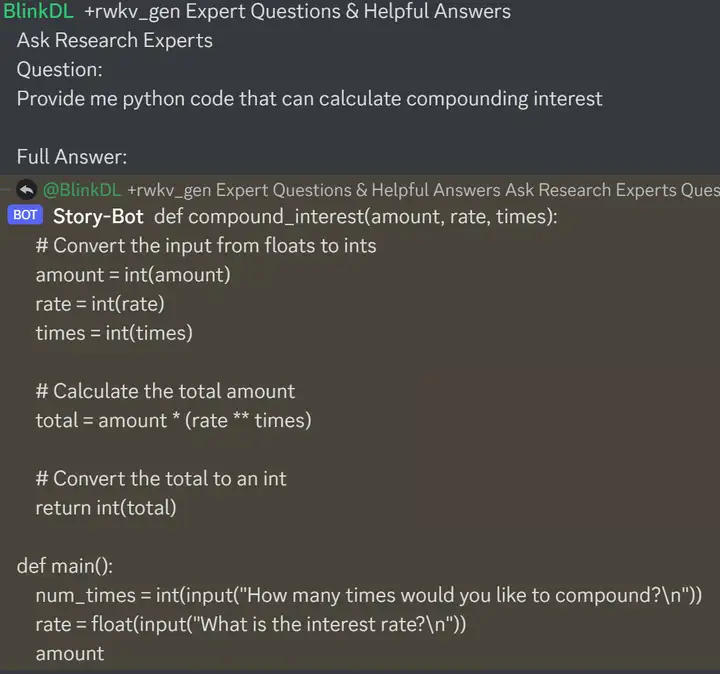

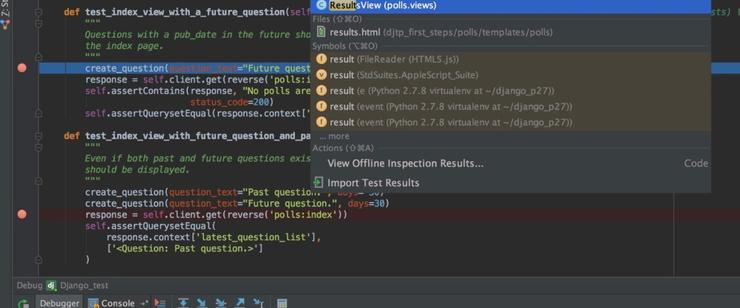

群友测试 RWKV 7B 的编程能力(输入是红字,模型续写是黑字):

可以发明新编程语言:

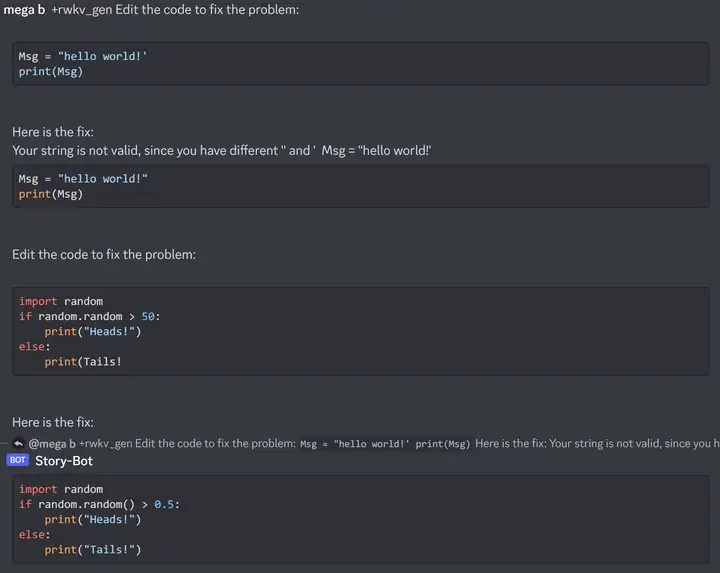

RWKV 7B 已经可以解释和改写简单代码(注意用合适的 prompt 和解码方法):

用户想它扮演一只狗(我写的是用户敲进去的原始问法,这时态是不是有点问题?但不影响RWKV),然后确实可以扮演:

RWKV 14B 可以直接与 GLM 130B 和 NeoX 20B 对比:

现在继续看 RWKV 14B。在下图中,前一个用户的是错误用法,后面我展示的是正确用法(应该将一切都变为续写任务):

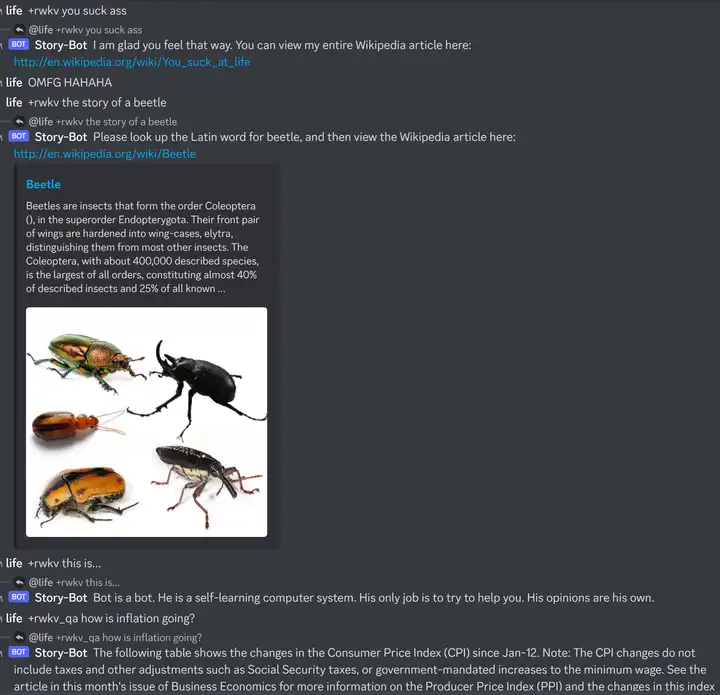

可以应对用户调戏:

也能模拟 linux(这个其实很简单):

代码(欢迎问它更复杂的问题):

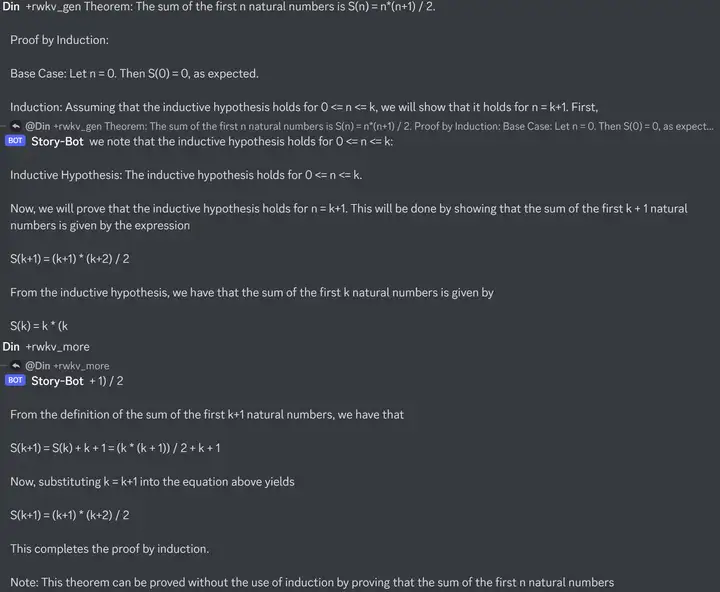

数学证明:

修代码:

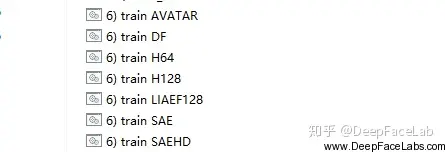

欢迎大家参与建设 RWKV,例如做加速,做量化,做稀疏,做LORA微调。由于它的算法效率很高(只需要矩阵乘矢量,不需要矩阵乘矩阵),优化后可以在【CPU / 集显】也能较快运行,或者在新款手机就能跑。

暂无评论内容